Czy kiedykolwiek zastanawiałeś się, w jaki sposób Google i inne wyszukiwarki decydują, które części Twojej strony internetowej mają trafić do indeksu, a które pozostaną pominięte? Kluczem do zrozumienia tego procesu jest niewielki, ale niezwykle istotny plik – robots.txt. Choć może wydawać się jedynie dodatkiem technicznym, w rzeczywistości odgrywa kluczową rolę w strategii SEO i optymalizacji serwisu.

W tym artykule Coolbrand wyjaśnimy, czym dokładnie jest robots.txt, jak działa, dlaczego jego konfiguracja ma ogromne znaczenie i jak możesz wykorzystać jego potencjał w budowie widoczności marki w Google.

Czym jest plik robots.txt?

Plik robots.txt to prosty dokument tekstowy, który znajduje się w głównym katalogu witryny internetowej (root directory). Jego główną funkcją jest przekazywanie wskazówek robotom indeksującym – czyli tzw. „botom” wyszukiwarek – odnośnie tego, które części serwisu mogą być skanowane i dodawane do indeksu, a które powinny zostać pominięte.

To część protokołu Robots Exclusion Protocol (REP), który powstał jeszcze w latach 90. XX wieku, aby umożliwić właścicielom stron większą kontrolę nad tym, co widzą wyszukiwarki.

Dlaczego robots.txt ma znaczenie dla Twojej witryny?

Plik ten może wydawać się niepozorny, ale jego odpowiednie skonfigurowanie to jeden z kluczowych elementów strategii technicznego SEO. Oto kilka powodów, dla których nie warto go ignorować:

Optymalizacja procesu indeksowania

Warto pamiętać, że wyszukiwarki mają ograniczony czas i zasoby na indeksowanie Twojej witryny – to tzw. crawl budget. Źle skonfigurowany serwis może marnować ten budżet na nieistotne podstrony, co sprawia, że kluczowe treści nie są widoczne w wynikach wyszukiwania. Dzięki robots.txt możesz skierować boty tylko tam, gdzie to naprawdę potrzebne.

Ochrona wrażliwych zasobów

Choć robots.txt nie jest mechanizmem bezpieczeństwa, możesz za jego pomocą zablokować indeksowanie sekcji administracyjnych, plików konfiguracyjnych, testowych wersji podstron czy treści tymczasowych, które nie powinny być dostępne w wyszukiwarce.

Unikanie duplikatów treści

Jeśli Twoja witryna zawiera wiele podstron o bardzo podobnej treści (np. filtry w sklepie internetowym), plik robots.txt może pomóc ograniczyć indeksowanie takich zasobów, zmniejszając tym samym ryzyko duplikacji contentu i negatywnego wpływu na ranking strony.

Jak działa plik robots.txt?

Działanie robots.txt opiera się na prostych dyrektywach, które są odczytywane przez roboty indeksujące w momencie, gdy odwiedzają Twoją stronę. To właśnie ten plik jest pierwszym miejscem, do którego zaglądają boty – zanim jeszcze zaczną skanować pozostałe treści.

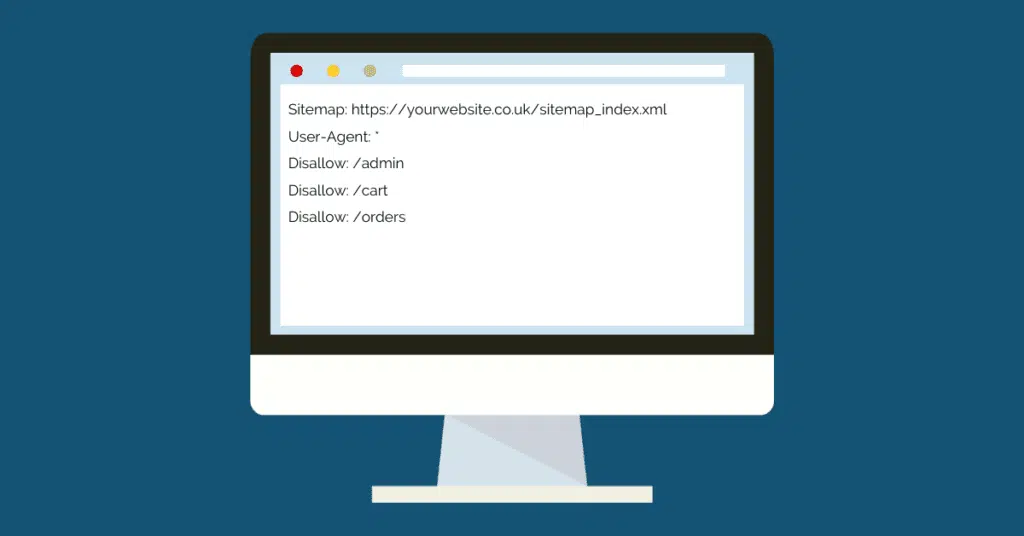

Najczęściej używane polecenia to:

- User-agent – określa, do którego robota odnosi się konkretna reguła (np. Googlebot, Bingbot). Można też użyć *, aby odnieść się do wszystkich botów.

- Disallow – informuje roboty, które ścieżki powinny zostać pominięte.

- Allow – pozwala na indeksację konkretnych podstron, nawet jeśli reszta katalogu jest zablokowana.

- Sitemap – wskazuje lokalizację mapy witryny XML, co ułatwia botom poruszanie się po strukturze strony.

Dzięki tym prostym poleceniom możesz stworzyć precyzyjną mapę dostępu dla botów wyszukiwarek – minimalizując błędy i maksymalizując efektywność działań SEO.

Przykłady zastosowań pliku robots.txt

Zastanawiasz się, jak wykorzystać robots.txt w praktyce? Poniżej przedstawiamy kilka realnych przykładów zastosowania:

- Blokowanie dostępu do panelu administracyjnego:

makefile

KopiujEdytuj

User-agent: *

Disallow: /admin/

- Zezwolenie na dostęp do jednej podstrony w zablokowanym katalogu:

vbnet

KopiujEdytuj

User-agent: *

Disallow: /private/

Allow: /private/regulamin.html

- Dodanie mapy witryny:

arduino

KopiujEdytuj

Sitemap: https://www.twojastrona.pl/sitemap.xml

Takie reguły można dowolnie modyfikować w zależności od potrzeb, struktury strony i celów SEO.

Jak utworzyć i edytować plik robots.txt?

Stworzenie pliku robots.txt nie wymaga specjalistycznej wiedzy programistycznej. Wystarczy:

- Otworzyć edytor tekstowy (np. Notatnik, Visual Studio Code).

- Wpisać odpowiednie dyrektywy.

- Zapisać plik jako robots.txt w formacie UTF-8.

- Umieścić go w głównym katalogu strony (np. przez FTP lub w menedżerze plików hostingu).

Jeśli korzystasz z systemu CMS (np. WordPress), możesz skorzystać z popularnych wtyczek, takich jak Yoast SEO czy All in One SEO, które oferują łatwe w obsłudze kreatory do generowania i edytowania robots.txt bez potrzeby ręcznego kodowania.

Testowanie poprawności robots.txt

Nawet najlepiej napisany plik robots.txt może przypadkowo blokować ważne sekcje strony. Dlatego zalecane jest regularne testowanie jego działania.

Najlepszym narzędziem do tego celu jest Google Search Console, które udostępnia narzędzie „Tester pliku robots.txt”. Pozwala ono na sprawdzenie, jak roboty Google interpretują Twoje reguły, i czy nie dochodzi do konfliktów.

Pamiętaj, że błędnie skonfigurowany plik może skutecznie „ukryć” Twoją stronę przed Google – co oznacza utratę widoczności, pozycji i ruchu organicznego.

Czy robots.txt to zabezpieczenie strony?

To bardzo częste nieporozumienie. Plik robots.txt nie chroni żadnych danych ani zasobów przed osobami trzecimi. Jeśli ktoś zna dokładny adres URL zablokowanej podstrony, nadal może ją odwiedzić.

Robots.txt to instrukcja dla wyszukiwarek, a nie mechanizm bezpieczeństwa. Niektóre boty – zwłaszcza te nieautoryzowane – mogą ignorować reguły pliku i próbować skanować całą witrynę mimo zakazów. Jeśli zależy Ci na prawdziwym bezpieczeństwie, musisz korzystać z metod takich jak uwierzytelnianie, hasła, nagłówki noindex lub zabezpieczenia serwera.

Czy każda strona potrzebuje pliku robots.txt?

Nie każda witryna musi mieć plik robots.txt, ale każda profesjonalna strona powinna go mieć. Dlaczego?

Bo jego brak może skutkować tym, że wyszukiwarki będą indeksować wszystko – włącznie z tym, co nie powinno być widoczne w sieci. Plik ten pozwala przejąć kontrolę nad tym procesem i dostosować go do strategii SEO, UX i struktury treści.

Podsumowując, dobrze skonfigurowany plik robots.txt to jeden z fundamentów nowoczesnego i przemyślanego SEO. Pomaga w efektywnym zarządzaniu zasobami witryny, poprawia bezpieczeństwo, zwiększa efektywność indeksowania oraz wspiera realizację celów marketingowych w wyszukiwarkach.

Jeśli prowadzisz biznes online, zarządzasz stroną firmową lub tworzysz treści w oparciu o strategię content marketingową – nie możesz ignorować tego elementu. W świecie, gdzie pozycja w Google to realna waluta, nawet tak prosty plik jak robots.txt może stać się Twoim cichym sprzymierzeńcem.